来源:未来智库

AI(人工智能):第四次生产力革命

AI(Artificial Intelligence):1952 年,图灵在《计算机械与智能》一文中提到了“图灵测试”来验证机器是否具有智能:如果一台机器能够与人类展开交流,并且有超过 30%的人无法在规定时间内识别出与自己交谈的是人还是机器,那么这台机器可以被认为是具有智能的。后来科技界又提出了其他界定人工智能的标准:例如能否实现语音识别、机器翻译、自动写作等等。本报告中所提及的人工智能技术,不仅包括具有自然语言处理能力、或通过图灵测试的AI 技术,还包括有海量数据、超复杂性、要求实时性、人类智能暂时无法处理的机器智能技术。

AI 发展原动力:提效降本,在新一轮技术革命中抢占先机微观:提效降本,科技让生活更美好从 C 端用户需求来看,人工智能解决的是与人相关的娱乐、出行、健康等生活场景中的痛点。人工智能在 C 端的应用分为两方面:1)对原有劳动力的替代与生产力效率的提升:如语音识别、智能客服、机器翻译等;2)新增需求的满足:如“千人千面”的信息分发(如抖音、快手、小红书等)、内容生成(AIGC)、人机交互(如 ChatGPT 等)、辅助驾驶、安防等。从 B 端需求来看,企业对于效率的提升需求旺盛,人工智能在金融、公共安全、医疗健康等领域均取得了较为普遍的应用。

宏观:新一轮技术革命,赢得未来国与国之间科技竞争的主动权人工智能有望引领了蒸汽革命、电气技术革命以及信息产业革命之后的第四次生产力革命。1)18 世纪 60 年代,英国率先发展并完成了第一次工业革命,在随后的一个多世界里成为了世界霸主;2)19 世纪 60 年代,完成了资产阶级革命或改革的美、德、法、日在第二次工业革命中崛起,使人类进入“电气时代”;3)进入 20 世纪中叶,以信息技术、新能源技术的代表的第三次科技革命在美国兴起,进一步强化了美国的霸主地位。自 2006 年以来,Hinton 提出深度学习算法,令机器在自主学习方面有了革命性的突破,同时,伴随着海量数据的积累、GPU、芯片计算能力的提升,人工智能的三大要素“算法”、“算力”和“数据”皆已准备就绪。2016 年,AlphaGo 首次击败人类问鼎世界冠军,人工智能的关注度急速攀升。而近期人工智能技术在安防、金融、医疗、内容分发领域的持续落地,使AI 技术在提效降本、解放劳动力、提升资源配置效率方面的巨大作用得以显现。我们认为,在本轮变革中具有良好技术沉淀和全面布局的国家有望抢得科技的主动权。

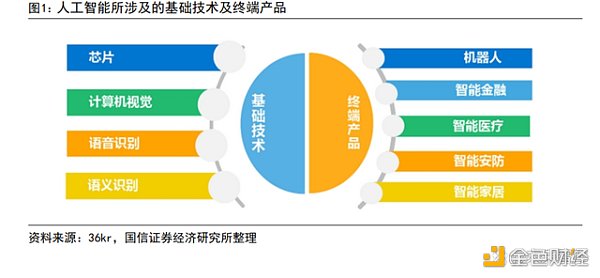

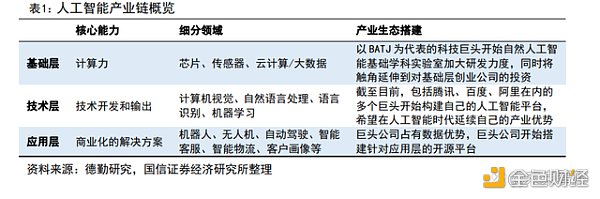

产业链及发展历程:三起两落,数据及算力爆发带来新一轮AI 发展机遇产业链:基础层+技术层+应用层总体来看,人工智能产业链可分为基础支撑层、技术层和应用层。基础层提供算力,主要包含人工智能芯片、传感器、大数据及云计算。其中,芯片具有极高的技术门槛,且生态搭建已基本成型。目前该层级的主要布局玩家为Nvidia、AMD、英特尔等在内的国际科技巨头,国内在基础层的布局和实力均相对薄弱。技术层主要解决具体类别问题,这一层级主要依托运算平台和数据资源进行海量识别训练和机器学习建模,开发面向不同领域的应用技术,包括语音识别、自然语言处理、计算机视觉和机器学习技术等。科技巨头谷歌、IBM、亚马逊、苹果、阿里巴巴、百度都在该层级深度布局,并涌现了如商汤科技、旷世科技、科大讯飞等诸多独角兽公司。应用层主要解决场景落地问题,利用AI 技术针对行业提供产品、服务和解决方案,其核心是商业化。得益于人工智能的全球开源社区,应用层的进入门槛相对较低,但也是商业价值最大的环节(典型如算法推动在抖音、快手等应用端落地)。

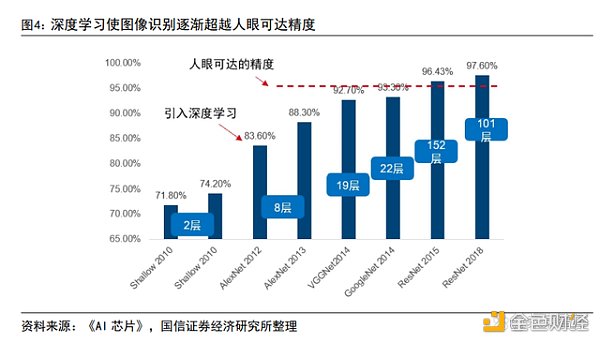

发展历程:60 年三起两落,呈螺旋式发展回顾人工智能技术的发展历程,我们发现,人工智能所经历的三次兴起浪潮均源于底层算法的革命性进展,而前两轮的衰落是由于数据处理性能及底层算法的局限,使 AI 技术从成熟度以及商业可行性上无法落地。2006 年,Hinton 提出颠覆性的深度学习算法,使得 AI 产业迈出关键性一步:利用多层神经网络,将人类从复杂的算法归纳中解放出来,只要给予机器足够多的数据,便能使其自动归纳出算法,叠加底层算力 GPU 的不断发展及互联网时代海量数据的积累,人工智三驾马车:算法、算力和数据皆已准备就绪,使 AI 技术彻底走出实验室,逐步渗透进各个行业和场景。第一轮:兴于感知神经网络,终于计算机性能约束兴起:1956 年达特茅斯会议开启了人工智能的元年,仅在定理层次等证明了AI商用的可能性,实际应用还十分有限。1956 年,以约翰·麦卡锡、马文·明斯基、克劳德·香农等为代表的科学家们在达特茅斯组织了一场为期两个月的人工智能夏季研讨会,探讨如何通过机器模拟人类学习或人类智能的其他特征。本次会议结束后,很多国家政府、研究机构、军方等都开始投资人工智能,掀起了第一波人工智能热潮。在第一波 AI 的浪潮中,占据主导地位的思想是逻辑主义,即通过引入符号方法进行语义处理、将待研究和解决的问题转化为可以用计算机处理的符号,运用逻辑公理进行解答,从而实现人机互动。第一波人工智能浪潮的总体成就有限,仅在定理证明等特定领域取得了成功。受制于计算机性能及可获取的数据量,当时的人工智能只能完成玩具式的简单任务,在语音、图像识别及想起游戏等看似简单的任务上,进展都十分有限。衰落:计算机的性能制约了早期程序的应用,人工智能的发展首次预冷。受限于计算机的处理性能,当时其所能处理的程序对象少且复杂度低,机器无法读取足够的数据实现智能化,AI 自然无法大规模落地商用。1973 年,学者莱特希尔发表了一份具有影响力的评估报告《人工智能:一般性的考察》,报告指出:“迄今为止,人工智能没有在任何领域发生之前预想的重大影响,人工智能的投入是金钱的浪费”,该报告发表后,英国政府随后终止了对爱丁堡等几所高效的人工智能项目的支持。到 70 年代中期,美国和其他国家在该领域的投入也大幅度削减,人工智能发展进入寒冬。第二轮:兴于 BP 神经网络,终于专家系统失败兴起:1980 年代,Hopfield 神经网络和 BT 训练算法的提出,使基于AI技术的专家系统首次得以商用。Hopfield 神经网络是通过对动物或人脑的基本单元一神经元建模和连接,探索模拟动物或人脑神经系统的学习、联想、记忆和模式识别等功能的人工模型。基于该模型,IBM 等公司开发出了一系列用于模拟专家决策的专家系统,使人工智能第一次实现商业化落地。衰落:算法局限使计算结遭遇瓶颈,人工智能由于实际商用成本过高再次衰落。专家系统的维护成本极高,但神经元网络只能解决单一问题,数据量积累到一定程度后,计算结果便不再改进,实际应用价值有限。1987 年,苹果和IBM生产的台式机性能超过了由 Symbolics 等厂商生产的通用计算机,专家系统逐渐淘汰。第三轮:兴于深度学习算法,强于数据及算力兴起: 2006 年,Hinton 提出了神经网络 DeepLearning 算法,将人类从复杂的算法归纳中解放了出来,使人工智能再一次聚焦了学术界和产业界的目光。从底层算法来讲,深度学习算法弥补了传统 BP 神经网络的缺陷:1)多隐层的人工神经网络具有优异的特征学习能力,从而有利于可视化或分类;2)传统人工神经网络的训练难度可以通过“逐层初始化”来克服。通俗来讲,本轮算法的革命性进步在于:不需要人工去提取规则特征,机器通过海量数据,即可自动实现规则的特征提取,将最复杂的“算法归纳”留给机器去完成。数据显示,自2012年在图像识别领域引入深度学习算法以来,图像识别的错误率显著降低。并通过深度学习训练层数的增长及优化,在 2015 年通过 ResNet 模型使图像识别的精度超过了人眼可达的精度。

DigiDaigaku将启动“DRAGON ESSENCE”免费空投:2月12日消息,DigiDaigaku母公司Limit Break首席执行官Gabriel Leydon在社交媒体发文称,该生态系统NFT持有者(包括Genesis、Heroes和Super Villains)将获得免费空投的“Dragon Essence”,“Dragon Essence”可以帮助婴儿龙成长进化,但Gabriel Leydon表示用于空投“Dragon Essence”的快照日期目前待定。

此前,Gabriel Leydon曾透露Limit Break将在北京时间2月13日举行的第57届超级碗中投放广告并开启新NFT免费铸造。[2023/2/12 12:02:12]

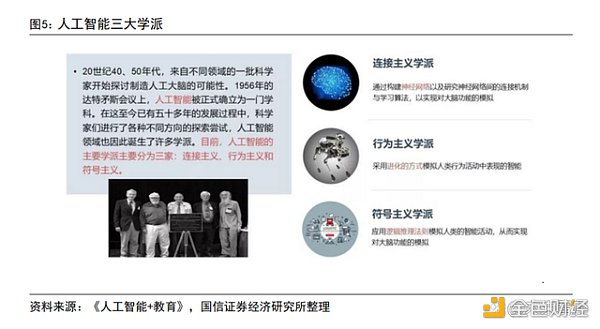

强化:底层算力的高速发展及多维数据的快速积累,使本轮人工智能得以爆发。计算机硬件设施的发展,如 GPU(图形处理器)、TPU(张量处理器)等新一代芯片及 FPGA(现场可编程门陈列)异构计算服务器提供了足够的计算力,能够支持人工智能算法的原型。数据的可获得性和质量在这一时期得到了极大的改善,互联网、物联网等产业的发展也为人工智能提供了规模空前的训练数据。人工智能三大要素:“算法、算力和数据”的准备就绪,使人工智能快速渗透到各产业中,如安防、金融、医疗、文娱等。人工智能:技术流派及我们所处的阶段技术演进:行为主义+连接主义,诞生深度学习技术AI 的技术流派经历了符号主义、连接主义和行为主义,在行为主义思想中引入了连接主义的技术,诞生本轮的深度强化学习技术。

符号主义

符号主义又称为逻辑主义 ,在人工智能早期一直占据主导地位。该学派认为人工智能源于数学逻辑,其实质是模拟人的抽象逻辑思维,用符号描述人类的认知过程。早期的研究思路是通过基本的推断步骤寻求完全解,出现了逻辑理论家和几何定理证明器等。上世纪 70 年代出现了大量的专家系统,结合了领域知识和逻辑推断,使得人工智能进入了工程应用。PC 机的出现以及专家系统高昂的成本,使符号学派在人工智能领域的主导地位逐渐被连接主义取代。连接主义连接主义又称为仿生学派 ,当前占据主导地位。该学派认为人工智能源于仿生学,应以工程技术手段模拟人脑神经系统的结构和功能。连接主义最早可追溯到1943年麦卡洛克和皮茨创立的脑模型,由于受理论模型、生物原型和技术条件的限制,在 20 世纪 70 年代陷入低潮。行为主义行为主义又称为进化主义,近年来随着 AlphaGo 取得的突破而受到广泛关注。该学派认为人工智能源于控制论,智能行为的基础是“感知—行动”的反应机制,所以智能无需知识表示,无需推断。智能只是在与环境交互作用中表现出来,需要具有不同的行为模块与环境交互,以此来产生复杂的行为。在人工智能的发展过程中,符号主义、连接主义和行为主义等流派不仅先后在各自领域取得了成果,各学派也逐渐走向了相互借鉴和融合发展的道路。特别是在行为主义思想中引入连接主义的技术,从而诞生了深度强化学习技术,成为AlphaGo 战胜李世石背后最重要的技术手段。

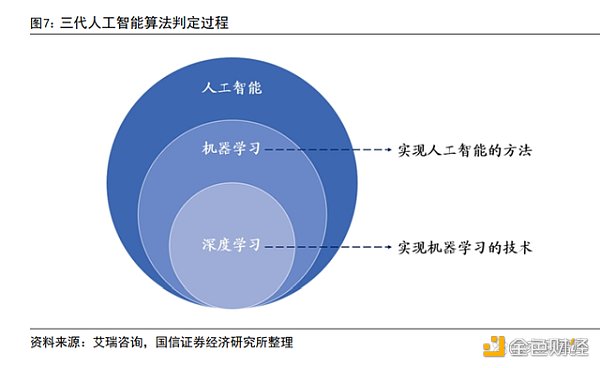

技术现状:深度学习技术带动本轮人工智能发展人工智能算法经历了“既定规则系统”、“浅层学习算法”和“深度学习算法”三个阶段,其中,深度学习算法彻底将人类从复杂的算法抽象中解放了出来,用深度神经网络+海量数据打破了计算准确度的瓶颈,带动了本轮人工智能的爆发。人工智能算法所经历的三大阶段及实现过程如下:

1)既定规则系统及其实现过程既定规则系统尚不属于“机器学习”的范围,其背后的关系为人力搭建算法的逻辑关系。面对待处理的问题,由人提取出问题特征、再由人设定好算法规则,交由机器进行运行。例如,判断某幅图片是否为猴子,既定规则系统执行过程如下:1)人为提取猴子各部分像素特征;2)人为设定猴子判定规则,如眼睛、鼻子、嘴巴等部位的像素应分别位于哪一区间内;3)机器根据读取到的像素及判定规则,计算当前图片是否为猴子,输出结果“是”或“否”。2)传统机器学习算法及实现过程传统机器学习算法彻底将人类从复杂的算法抽象中解放了出来,但对复杂数据的处理受到明显制约。简单来说,机器学习是一种实现人工智能的方法,深度学习算法是实现机器学习的技术。传统机器学习算法又称浅层算法,这类算法如反向传播算法(BP 算法)、支持向量机(SVM)、Boosting 等,局限性在于对有限样本和计算单元的情况下对复杂函数的表示能力有限,对复杂数据的处理受到制约。例如,在图像识别领域,浅层学习的识别准确率较低,主要原因为该算法的处理逻辑偏向浅层,不能穷举复杂的情景,在准确率达到一定程度后,即使再投入更多数据,准确率依然无法提升。如判断某幅图片是否为猴子,传统机器学习算法执行过程如下:1)人为提取猴子各部分像素特征;2)机器自动归纳猴子的判定规则,如眼睛、鼻子、嘴巴等部位的像素应分别位于哪一区间内;3)机器根据读取到的像素及判定规则,计算当前图片是否为猴子,输出结果“是”或“否”。3)深度学习算法及实现过程

The Beacon或将与NFT项目DigiDaigaku达成合作:12月11日消息,Treasure生态链游The Beacon继宣布与全链NFT游戏Ether Orcs合作为其创世NFT持有者在游戏中免费提供独家NFT后,询问NFT项目DigiDaigaku CEO Gabriel Leydon是否为DigiDaigaku持有者添加类似资产。对此Gabriel Leydon表示认可,称将立即私信联系。[2022/12/11 21:37:02]

深度学习与传统的机器学习最主要的区别在于:随着数据规模的增加,其判断准确度也在不断增长。判断准确度的提升,使人工智能技术可大规模应用于语音识别、图像识别等多个领域。2006 年,Hinton 提出深度学习算法,该算法与传统的机器学习算法最大的区别在于随着数据规模的增加,算法计算准确率也不断增长。当数据很少时,深度学习算法的性能并不突出,随着数据量的增加,其优越性得以体现。传统机器学习算法,在拟合度达到某一特定值后,再增加数据量,其拟合度不再提升;深度学习算法拟合准确度随着数据量及神经网络层数的增加而提升。例如,在引入深度学习之前,语音识别的准确率连续三年稳定在 76.4%,引入该算法后,其准确率逐年递增,2017 年已达94.5%。如判断某幅图片是否为猴子,深度学习算法的执行过程如下:人为将海量带有标签的图像数据到计算机中,无需进行任何特征提取或规则设定,算法自动根据输入图像的特征归纳出判定规则,并泛化至后续判断过程中。

实现要素:海量数据及高效算力是深度学习实现基础

海量数据及高效算力是深度学习实现基础。深度学习全称深度神经网络,本质上是多层次的人工神经网络算法,即从结构上模拟人脑的运行机制,从最基本的单元上模拟了人类大脑的运行机制。算法的实现过程分为训练和推断两个阶段。训练阶段需要海量数据输入,训练出一个复杂的深度神经网络模型。推断指利用训练好的模型,使用待判断的数据去“推断”得出各种结论。大数据时代的到来,图形处理器(Graphics Processing Unit,GPU)等各种更加强大的计算设备的发展,使得深度学习可以充分利用海量数据(标注数据、弱标注数据或无标注数据),自动地学习到抽象的知识表达,即把原始数据浓缩成某种知识。简单来说,在深度学习算法的基础上,海量数据解决了计算精准度的问题,算力的提升解决了计算速度的问题。

所处时代:基于统计规律的弱人工智能时代,但商业化价值已经展现

人工智能的分类标准及定义

李开复及王咏刚在《人工智能》一书中,将人工智能按照智能程度的强弱,划分为:弱人工智能(Artificial Narrow Intelligence,简称ANI)、强人工智能(Artificial General Intelligence,简称 AGI)和超人工智能(ArtificialSuperintelligence,简称 ASI)三个层次。

弱人工智能(ANI)也称为限制领域人工智能或应用型人工智能,本质上是某个特定领域内基于统计规律的大数据处理者。通俗来讲,弱人工智能只专注于完成某个特定的任务,例如语音识别、图像识别和翻译,是擅长单个方面的人工智能,类似高级仿生学。该阶段的 AI 技术是为了解决特定具体类的任务问题而存在,底层原理是从海量数据中从中归纳出模型,再泛化至新的数据中进行正向运算。例如,谷歌的 AlphaGo 和 AlphaGo Zero 就是典型“弱人工智能”,尽管它们能够战胜象棋领域的世界级冠军,但也仅限于擅长于单个游戏领域的人工智能。

强人工智能(AGI)是人类级别的人工智能,拥有独立思想和意识,在各方面均能与人类媲美。拥有 AGI 的机器不仅是一种工具,其本身可拥有“思维”,能够进行独立的思考、计划、解决问题、抽象思维、理解复杂理念、快速学习等,可实现“全面仿人性”,在智力水平和行动能力方面与人类基本没有差别,目前只存在于电影及人类想象中。

超人工智能:假设计算机程序通过不断发展,智力水平可以超越人类,则由此产生的人工智能系统就可以被称为超人工智能。在人工智能的三个层级中,超人工智能的定义最为模糊,目前还没有精准预测能够说明超越人类最高水平的智慧到底会表现为何种能力。对于超人工智能,目前只能从哲学或科幻的角度加以想象。

当前人工智能现状:基于统计规律的弱 AI 时代

当前人工智能尚属于“弱人工智能”阶段。按照人工智能的执行深度,我们将人工智能的判定层次分为计算智能、感知智能和认知智能三个层次:1)计算智能:神经网络和遗传算法的出现,使机器能够高效、快速地处理海量数据,目前该技术的应用已相当成熟;2)感知智能:技术已相对成熟,典型应用语音识别及人脸识别,准确率分别超过 98%和 99%;3)认知智能:还有较大提升空间,典型应用包括机器翻译和计算机视觉认知,这两项技术与人力还有较大差距。通过以上对三个层级的分析,我们判断:人工智能技术尚不具备完全“认知”能力,处于垂直领域的应用投入商用、自主认知尚待攻克的“弱人工智能”阶段。

Craig Wright的“中本聪”身份遭门罗币开发者等人质疑:6月20日消息,近日,一直在比特币基金会担任首席科学家职务的Gavin Andersen在法庭上确认曾经收到Craig Wright(澳本聪)申请比特币基金会工作的邮件。?对此,门罗币开发者Riccardo Spagni发推文质疑:“为什么比特币开创者Craig Wright需要寻求一份比特币基金会的工作呢?”(U.Today)[2020/6/20]

“弱人工智能”所带来的收效依然十分可观

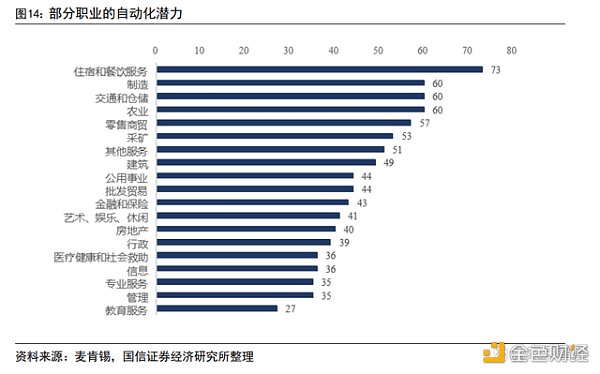

弱人工智能在特定领域的表现均超过人类,多种劳动密集型工作均具有较强自动化潜力。2017 年 10 月,AlphaGo 的升级版本实现了不通过向人类学习,只通过概率计算和自学自练就达成自我超越、战胜李世石的初代AlphaGo。由IBM开发人工智能 Waston,使用机器学习来分析和解读海量医疗数据和文献,检查患者数据做出治疗决定,印度班加罗尔研究表明,Waston 与医生在提供肺癌、结肠癌和直肠癌治疗建议方面一致性比例分别高达 96%、81%和93%。微软公司的人工智能虚拟机器人小冰,学习了 20 世纪 20 年代以来 519 位诗人的现代诗,自2017年2月起,“小冰”在天涯、豆瓣、贴吧、简书四个平台上使用了27 个化名发表的诗歌作品,几乎没有被发现是机器所作。不仅如此,人工智能在交通、教育、金融领域也展示出了巨大的应用前景。与人类相比,人工智能在数据存储、调用、分析处理方面的强大能力,以及在特定危险情境下的生存能力,都有望为人类生活带来巨大颠覆。麦肯锡报告表明,多种人力劳动密集、机械类工作都具有较强的自动化潜力,住宿和餐饮服务、制造、交通和仓储等职业自动化潜力巨大。

2020 年,弱人工智能为全球 GDP 带来 14%的提升。人工智能将提升社区劳动生产率,特别是在有效降低劳动成本、优化产品和服务、创造新市场和就业等方面,将为人类的生产和生活带来革命性的转变。据 Sage 预测,2020 年,人工智能的出现将为全球 GDP 带来 14%的提升,相当于 15.7 万亿美元的增长。根据世界银行及产新智库的分析,人工智能作为当下最先进生产力,如果能为制造业提高1%的效率,全球制造业便会节约 3000 亿美元。再细分到各个产业,为航空提高1%的效率相当于 300 亿美元,为电力提高 1%的效率相当于660 亿美元,为医疗系统效率提高 1%相当于 630 亿美元,为铁路系统效率提高1%相当于270 亿美元,为石油天然气资本支出降低 1%相当于 900 亿美元。综上,截至2025 年,人工智能可能影响 32 万亿美元的全球制造业领域,相当于将影响全球50%的经济。

万事俱备,人工智能场景应用有望全面爆发

相比于前两轮的 AI 浪潮,我们认为本轮人工智能应用将全面爆发的原因如下:1)深度学习算法的革命性颠覆,使“数据量”成为决定拟合结果的核心要素:在本轮深度学习算法出现前,AI 的主要算法是 BP、SVM 等浅层算法,由于其处理逻辑停留在浅层,即使在拥有海量数据的情况下,拟合结果的准确率在提升至某一瓶颈后便无法提升,人工智能难以处理复杂的问题。深度学习算法得益于多层神经网络,可直接用海量数据“暴力破解”出计算算法,数据量越高,拟合精准度越高。这说明只要具备充足的数据和算力,便能快速训练出精准的算法,这使得决定人工智能准确度的核心由“算法”转变为“数据和算力”;2)海量多维数据及GPU 算力已准备就绪,为算法运行提供充足“燃料”和“引擎”:互联网使海量数据积累成为可能,而 GPU 的出现,满足了机器学习大规模并行计算要求。至此,人工智能的三驾马车“算法、算力、数据”皆已准备就绪;3)开源框架大幅降低了 AI 的使用门槛;4)政策及资本的助力:AI 被广泛认为人类历史上第四次工业革命,美国、中国等科技大国均将其提升至顶层战略高度,加之资本注入及催化,“弱人工智能”的商用已广泛落地。

资源层:数据及算力的大幅提升将 AI 推向浪潮之巅

互联网及数字经济的快速发展,为 AI 算法训练提供充裕的数据来源。人工智能领域顶级专家吴恩达曾提到:发展人工智能就像用火箭发射卫星,需要强大的引擎和足够的燃料,算法模型就是其引擎,高性能的算力是打造引擎的工具,海量的数据就是引擎的燃料。基于深度学习的算法特点,其计算准确度与数据量基本成正比。例如,在输入 30 万张人类对弈棋谱并经过3000 万次自我对弈后,人工智能 AlphaGo 具备了媲美顶尖棋手的棋力。当前,机器学习所能应用的数据已经不局限于文本、数字等结构化数据,还包括视频、音频、图片等非结构化数据。而根据 IDC 的统计数据,2021 年全球数据量已经达到82 ZB,预计到2026年将达到 214 ZB。

动态 | 美国财政部长前助手Craig Phillips将加入Ripple董事会:曾担任美国财政部长Steven Mnuchin高级助手的Craig Phillips将加入Ripple董事会,这家数字转账公司正在关于虚拟货币的审查加强之际,扩大其在华盛顿的影响力。(彭博社)[2019/10/22]

GPU 的发展解决了深度学习的训练速度和相应的成本问题。1)英伟达于2016年推出 P100,2017 年推出 V100,2020 年推出 A100,4 年间从P100 至A100英伟达GPU 芯片高性能计算能力提升 11 倍。2022 年英伟达持续迭代推出H100,其最新的 H100 芯片在 A100 的基础上将训练表现提升 9 倍;2)算力芯片的快速迭代使得提升 AI 模型训练速度和下游用户体验,同时基于摩尔定律的算力提升也使得单位算力开销持续下降,从技术成熟度和商业化成本两端加速AI 技术走向普及。

技术环境:开源框架大幅降低开发门槛

各巨头在 2016 年纷纷创立 AI 开源的开发框架,人工智能的开发框架是底层硬件与上层软件之间的纽带,可以视作人工智能进行开发和应用的“操作系统”。以往的专家系统是基于本地化专业知识进行运算,以知识库和推理机为中心进行展开,推理机设计内容由不同的专家系统应用环境决定,不具备通用性。同时,知识库是开发者收集录入的专家分析模型与案例的资源集合,只能在单机系统环境下使用且无法连接网络,升级更新不便。企业的软件框架实现有闭源和开源两种形式,少数企业选择闭源方式开发软件框架,目的是打造技术壁垒;目前,业内主流软件框架基本都是基于开源化运营,如谷歌的TensorFlow、脸书的Torchnet、微软的 DMTK、IBM 的 SystemML、三星的 VELES 等,均具有分布式深度学习数据库和商业级即插即用功能。

外部环境:政策助力,人工智能迎来发展良机

中国密集出台人工智能相关政策,并将 AI 上升至国家战略,力求在下一轮工业革命中抢占先机。自 2015 年以来,国内不断出台推动人工智能发展的鼓励政策,包括:1)建立人工智能促进机制;2)为人工智能提供近支持,包括税收优惠、财政扶持及制定金融政策等;3)推动创新,包括促进产业集群,布局创新基地,鼓励人才培养;4)政府制定规制与保障措施等。

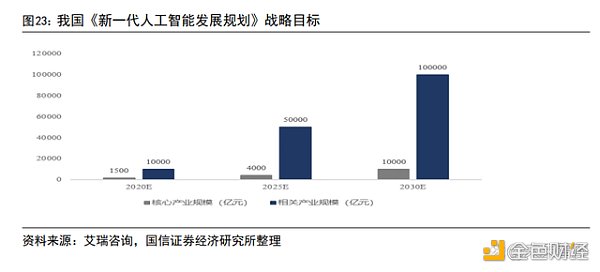

《新一代人工智能发展规划》提出了“三步走”战略目标,加速AI 再各行业渗透落地。第一步,到 2020 年,人工智能总体技术和应用与世界先进水平同步,人工智能产业成为新的重要经济增长点,核心产业规模超过1500 亿元,带动相关产业规模超过 1 万亿元;第二步,到 2025 年,新一代人工智能在智能制造、智能医疗、智慧城市、智能农业、国防建设等领域得到广泛应用,核心产业规模超过 4000 亿元,相关产业规模超过 5 万亿元;第三步,到2030 年,人工智能理论、技术与应用总体达到世界领先水平,形成涵盖核心技术、关键系统、支撑平台和智能应用的完备产业链和高端产业群,人工智能核心产业规模超过1万亿元,带动相关产业规模超过 10 万亿元。

从算法推荐到内容生成:AI 有望引发新一轮内容与平台投资周期

基于对 AI 产业链及成长历程的分析,我们认为,AI 底层算法和理论体系的突破相对缓慢,AI 对于各个行业的渗透和改造进度各不相同。但是当前基于神经网络的深度学习算法已经在感知层(图像、声音等)及部分认知处理环节逐步步入技术成熟期,在特定技术环节和应用场景中已经具备良好的商用价值。我们认为,短期内 AI 能够创造价值的行业必须具备以下三点要素:1)适合的场景应用:一方面行业内存在需求,AI 的应用能够解决实际问题,真正为行业带来降本提效;另一方面,深度学习的特点决定了 AI 的算法体系必须拥有特定领域的样本数据持续训练;2)充足的数据来源:在技术应用背后拥有足够的数据来驱动AI 能力的提升;3)所需技术具备商业可行性(技术成熟度以及成本、效率等)。

结合以上三方面要素,从落地的角度来看,AI 在自动驾驶、安防、语音识别等领域已经得到大规模应用;从传媒互联网领域落地来看,基于AI 的算法推荐已经在信息分发领域获得充分应用,并诞生出以字节跳动(今日头条、抖音等典型APP)、小红书为代表的移动互联网时代信息分发平台新范式;从信息分发到内容生成(AIGC),AI 有望重塑内容及互联网产业生态。

AI 赋能,字节跳动充分展现内容分发时代AI 商业化价值

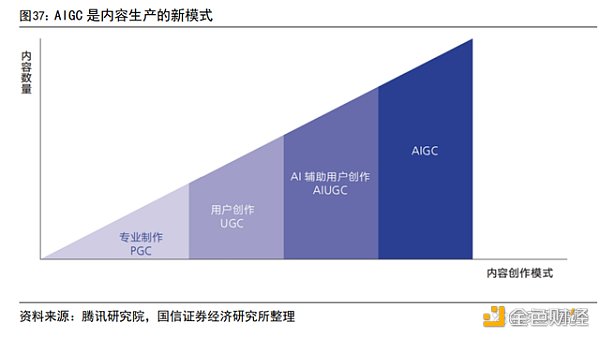

互联网时代信息爆炸,信息过载加速 AI 在内容分发领域落地。在互联网、特别是移动互联网的快速渗透推动之下,内容创作从传统的PGC 向UGC、PUGC模式转变,与之相应的是信息产生的数量呈现指数级上升;传统的用户主动获取信息的模式不堪重负、信息过载成为制约互联网产业发展的重要障碍;基于AI的“千人千面”算法推荐模式在此背景下快速导入,推动了互联网从“人找信息”到“信息找人”的内容分发模式转变。

声音 | Roger Ver:Craig Wright是否是中本聪并不重要:据CCN报道,比特币耶稣Roger Ver称,他100%赞成“锁定协议”,以便可以继续在其上建立事业并依赖它。然而支持SV的人(例如Craig Wright和Calvin Ayre)“擅长说”同样的话,但是他们的行为恰恰相反。Ver表示,Craig Wright是否是中本聪并不重要。如果事实证明他就是中本聪,那么这只会降低其对中本聪的看法。[2018/11/20]

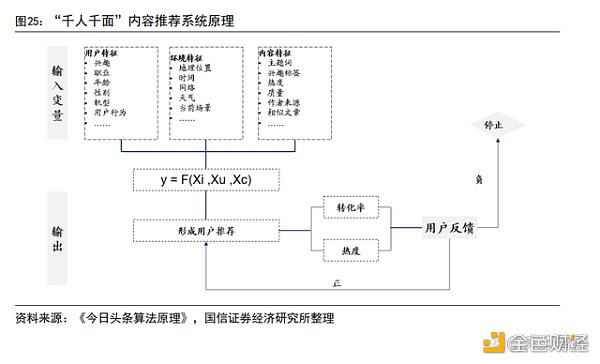

技术解读:“千人千面”的推荐系统本质上是一个由AI 技术驱动的拟合函数,输入变量包括用户特征、环境特征和内容特征,输出变量为推荐结果。参与运算的参数包括:1)用户特征:包括兴趣、职业、年龄、性别、机型、用户反馈行为等;2)环境特征:地理位置、时间、网络、天气、当前场景(工作、地铁等);3)内容特征:主题词、兴趣标签、热度、质量等。结合三方面的信息,模型会运算出一个预估,即推测推荐内容在这一场景下对这一用户是否合适。然后对小批量相同标签的用户进行实时推荐。如果用户反馈(转化率、热度)达到设定标准,则将此内容进行大规模的推荐;如果用户反馈低于设定标准,则停止推荐。依靠该推荐系统,使平台长尾内容实现了有效的分发和触达。

从技术理念到产品落地,算法推荐引领内容分发进入新时代。从产品来看,以抖音、今日头条、小红书等 C 端娱乐内容为代表的内容平台,基于海量用户数据,并通过视频识别技术,挖掘出各视频内容的特点及标签,通过推荐系统,将合适的内容、在合适的地点、推送给合适的人,改变内容分发行业聚焦于头部内容的生态特征,挖掘出长尾内容的使用价值;而从当前移动互联网产品来看,从内容分发到电商平台产品推送,基于 AI 的信息分发已成标配。

从产品到商业化,字节跳动的异军突起验证 AI 强大的生产力价值和商业化潜力。作为作为 AI 技术驱动型公司,字节跳动于 2012 年8 月推出首款新闻资讯分发产品“今日头条”,产品基于机器学习技术,实现“千人千面”的新闻信息推送。在上线不到两年的时间内,用户数已超过 1.2 亿,MAU 超过4000 万。后续,公司基于今日头条所打磨出的智能推荐系统,低成本、大规模生产“流产品”,推出了“抖音”等现象级产品,并将国内成熟产品通过“技术出海+本土化运营”顺利推广到全球。Questmoblie 数据显示,截至 2022 年底,字节跳动旗下产品合计用户时长占比达到 24.5%(2017 年底为 10.1%),成为仅次于腾讯系的互联网巨头。

生成式 AI(AIGC):从信息分发到内容生成,更为宏大的时代机遇

利用人工智能方式生成内容的想法发源甚早。艾伦·图灵(Alan Turing)1950在论文《计算机器与智能( Computing Machinery and Intelligence )》中提出了判定机器是否具有“智能”的试验方法,即“图灵测试”,判断标准为,机器是否能模仿人类的思维方式并生成内容进一步与人交互。半个世纪的科技发展中,随着数据量快速积累、算力性能不断提升、算法效力增强,当前的AI 在与人交互的过程中还可产出写作、编曲、绘画、视频制作等内容。2018 年,世界上首个出售的 AIGC 画作在佳士得拍卖行以 43.25 万美元成交,引发各界关注。随着AI的内容生成能力不断增强,场景落地开花,AIGC 产业浪潮兴起。结合人工智能的演进历程,AIGC 的发展大致可以分为4 个阶段,即: 早期萌芽阶段(20 世纪 50 年代至 90 年代中期)、沉淀积累阶段(20 世纪90 年代中期至21 世纪 10 年代中期) ,快速发展阶段(21 世纪10 年代中期至今)以及当前的破圈爆发阶段(2022 年至今)。

早期萌芽阶段 (1950s-1990s) :技术所限,AIGC 局限于小范围实验。1957年,莱杰伦·希勒 (Leiaren Hiller ) 和伦纳德·艾萨克森( LeonardIsaacson)通过将计算机程序中的控制变量换成音符得到了历史上第一支由计算机创作的音乐作品——弦乐四重奏《依利亚克组曲 ( Illiac Suite )》。1966 年,世界第一款可人机对话的机器人“伊莉莎 ( Eliza)”问世,其可在关键字扫描和重组的基础上进行人机交互。80 年代中期,IBM 基于隐形马尔科夫链模型( HiddenMarkovModel,HMM) 创造了语音控制打字机“坦戈拉( Tangora )”,能够处理约20000个单词。然而在 20 世纪末期,高昂的研发与系统成本与难以落地商业变现模式,各国政府减少了对人工智能领域的投入,AIGC 发展暂时停滞。

沉淀积累阶段 (1990s-2010s):AIGC 实用性增强,开启商业化探索。2006年,深度学习算法取得重大突破,且同期图形处理器( Graphics Processing Unit,GPU)、张量处理器( Tensor Processing UnitTPU) 等算力设备性能不断提升。数据层面互联网的发展引发数据规模快速膨胀,成为 AIGC 发展的算法训练基础,AIGC发展取得显著进步。但算法仍然面临瓶颈,创作任务的完成质量限制了AIGC的应用,内容产出效果仍待提升。2007 年,纽约大学人工智能研究员罗斯·古德温装配的人工智能系统通过对公路旅行中见闻的记录和感知,撰写出世界第一部完全由人工智能创作的小说《1 The Road》。但其仍整体可读性不强的劣势,存在拼写错误、辞藻空洞、缺乏逻辑等问题。微软 2012 年公开展示的全自动同声传译系统,基于深层神经网络 (Deep Neural Network,DNN)可自动将英文演讲者的内容通过语音识别、语言翻译、语音合成等技术生成中文语音。

快速发展阶段(2010s-2021):深度学习算法的不断迭代促进内容生态百花齐放。2014 年以来,以生成式对抗网络 (Generative Adversarial Network,GAN)为代表的深度学习算法被提出和迭代更新,AIGC 进入生成内容多样化的时代,且产出的内容效果逼真到难以分辨。2017 年,世界首部全部由AI 创作的诗集《阳光失了玻璃窗》由微软的人工智能少女“小冰”创造。2018 年,英伟达了可以自动生成图片的 StyleGAN 模型,截止 2022 年末,其已升级到第四代StyleGAN-XL,可生成人眼难以分辨真假的高分辨率图片。2019 年,DeepMind 发布了可生成连续视频的 DVD-GAN 模型。2021 年,OpenAI 推出了 DALL-E,并于2022 年将其升级为DALL-E-2。该产品主要生成文本与图像的交互内容,可根据用户输入的简短描述性文字,得到极高质量的卡通、写实、抽象等风格的图像绘画作品。

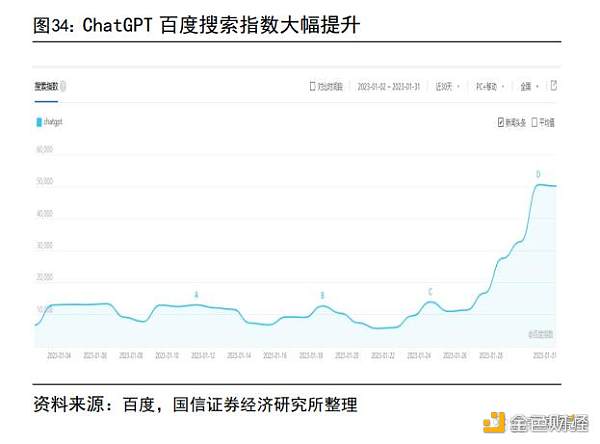

爆发与破圈阶段(2022-至今):2022 年以来,AIGC 产品密集发布,ChatGPT爆火出圈。Google 于 2022 年五月推出了文本图像生成模型lmagen,同年8月,开源 AI 绘画工具 StableDiffusion 发布;2022 年 9 月,Meta 推出可利用文字生成视频的产品 Make-A-Video 以推动其视频生态的发展。2022 年11 月30 日,OpenAl推出 AI 聊天机器人 ChatGPT,AIGC 的内容产出能力迅速吸引大批用户,至2022年 12 月 5 日,根据 OpenAI 创始人表示,ChatGPT 用户数已突破100 万。2023年2 月,微软宣布推出由 ChatGPT 支持的新版本 Bing 搜索引擎和Edge 浏览器,AIGC与传统工具进入深度融合历程。

算力与数据皆备、大模型加速 AIGC 技术导入,应用创新、场景落地渐行渐近

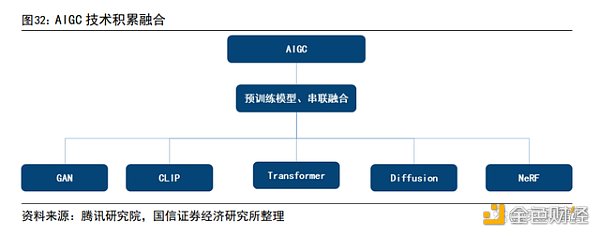

深度模型的进步与创新奠定 AIGC 走向成熟的基础。就底层技术而言,不断创新的生成算法、预训练模型、多模态等技术是 AIGC 行业发展的前提,以此为基础AIGC在自动化内容生成上具备了通用性、基础性多模态、参数多、训练数据量大、生成内容高质稳定等特征优势。

预训练模型进一步打开了 AIGC 的技术和商业化可能。以往的生成模型存在使用门槛高、训练成本高、内容生成简单和质量偏低等劣势,而真实内容消费场景具备灵活多变、高精度、高质量等痛点要求。预训练模型的出现通过提高AIGC技术能力解决了上述问题。AI 预训练模型。即大模型、基础模型(FoundationModel),其基于大量数据与巨量参数的模型,可适应下游广泛任务并显著提高各种下游任务的性能。AIGC 进入预训练模型时代以 2018 年谷歌发布基于Transformer机器学习方法的自然语言处理预训练模型 BERT 为标志。当前按照基本类型分类,预训练模型包括:(1)自然语言处理(NLP) 预训练模型,如谷歌的LaMDA 和PaLM、OpenAl 的 GPT 系列;(2)计算机视觉(CV)预训练模型,如微软的Florence:(3)多模态预训练模型,即融合文字、图片、音视频等多种内容形式。

以 GPT 为代表的大模型表现优异,AIGC 加速从实验室设想向产业化落地。1)根据 IDC 的定义,AI 大模型是基于海量多源数据打造的预训练模型,是对原有算法模型的技术升级和产品迭代,用户可通过开源或开放API/工具等形式进行模型零样本/小样本数据学习,以实现更优的识别、理解、决策、生成效果和更低成本的开发部署方案。大模型的核心作用是突破数据标注的困境,通过学习海量无标注的数据来做预训练,拓展整体模型前期学习的广度和深度,以此提升大模型的知识水平,从而低成本、高适应性地赋能大模型在后续下游任务中的应用;2)以GPT 系列自然语言处理模型为例,从 2018 年 6 月的GPT-1 模型,经过数代的模型迭代,GPT3.5 已经从早期的 1.17 亿参数量提升至当前的千亿级以上,而基于GPT3.5 的 ChatGPT 在人机对话中表现优异并火爆出圈,印证了大模型在文本、图像乃至视频等领域内容生成的可能性和商业化潜力。

从 PGC 到 AIGC,AI 有望重构内容与媒介生态

AIGC 多样化的内容生成能力使其覆盖各类内容形式,各类应用场景正随技术进步逐渐落地。AIGC 不仅可覆盖文本、音频、图像、视频等基本内容模态,还可综合图像、视频、文本进行跨模态生成,并应用于各类细分行业成为具体的生产力要素,例如游戏行业中的 AI NPC、虚拟人的视频制作与生成等。

从 PGC 到 AIGC,内容与平台从生态到商业模式有望重塑,新投资周期即将来临。1)从 PGC 到 UGC、PUGC,传媒互联网从 web 1.0 的门户时代进入到移动互联网的web 2.0 时代,结合算法推荐的信息分发模式诞生了以字节跳动(抖音、今日头条)、美团、快手、小红书等为代表移动互联网新贵;2)算法推荐重塑了信息分发模式,而 AIGC 则实现了信息、内容的 AI 创作,内容生产将从PGC、UGC、PUGC迈入 AIGC 时代,内容生产的效率有望实现跨越式提高,内容将迎来大爆发时刻,与之相应的,从内容到媒介平台都将会迎来生态和商业模式的重塑,内容与平台的新投资周期即将来临。

投资分析

AI 是新一轮生产力革命,算法创新及算力进步、数据爆发,催化本轮人工智能奇点将至。1)人工智能(AI)基于机器学习和数据分析的方法,赋予机器人类的能力,从而实现解放人力、降本提效的目的,已经成为推动新一轮生产力革命的核心技术方向;2)经历符号主义、连接主义和行为主义的持续演进,最终诞生了引导本轮 AI 落地的深度学习技术;深度学习技术的出现,改变了传统AI 的技术路线,解决了传统机器学习算法无法处理大量数据、准确率遭遇瓶颈的问题,使得AI 从理论上具备了工程化落地的可能;基于摩尔定理的算力提升,互联网及数字经济的快速发展带来的数据量井喷,使得 AI 最终从设想走向场景落地,在语音识别、图像识别等领域的计算准确度都实现了突破性进展并得到广泛应用。

从算法推荐到内容生成,AIGC 有望带动新一轮内容与平台革命。1)从传媒互联网的实践来看,基于 AI 算法推送的信息分发模型已经为web 2.0 时代主流的信息组织模式,并诞生出以字节跳动、快手、小红书等为代表典型产品和商业案例;2)从算法推动到内容生成(AIGC),新时代的大门正在打开:海量的数据资源、快速提升的算力水平和不断降低的单位算力成本开销、基于深度学习的预训练大模型构建的通用大模型显著降低应用开发门槛,数字化的高渗透率赋予充裕场景应用可能;从 PGC 到 AIGC,内容生产的大爆炸将重塑内容与平台生态、商业模式,新一轮产业机遇渐行渐近。

未来智库

个人专栏

阅读更多

金色财经 善欧巴

金色早8点

Arcane Labs

MarsBit

Odaily星球日报

欧科云链

深潮TechFlow

BTCStudy

澎湃新闻

2023 会是 ZK 大年吗?ZK 作为 L2 、隐私、跨链等概念下的核心技术派系,该板块热度自 2022 年延续至今;近期的 ETHdenver 大会上,ZK 持续高热.

1900/1/1 0:00:00撰文:Mary Liu加密社区最期待的大事之一 --Arbitrum 空投 -- 终于来了。Arbitrum Foundation 宣布将于 3 月 23 日向其社区成员空投 ARB 治理代币,

1900/1/1 0:00:00在不断发展的加密货币投资世界中,您是否经常感到落后?您是否发现难以跟上市场上风险投资 (VC) 的最新动向?好吧,不要害怕,因为有各种工具和资源可以帮助您随时了解情况并保持领先地位.

1900/1/1 0:00:00原文:Crypto.comAI 已经跃升到一个新的水平,现在正在帮助构建 Web3。 本文将帮你了解生成式 AI 将如何塑造 Web3 的未来.

1900/1/1 0:00:00文/Aurelie Barthere,Nansen首席研究分析师;译/金色财经xiaozou本文要点:· Arbitrum基金会与Offchain Labs合作.

1900/1/1 0:00:00原文作者:Luyao原文来源:twitter注:本文来自/img/2023525220340/0.jpg" />https://twitter.

1900/1/1 0:00:00