由HillTan和GraceDeng所著,SevenXVenturesResearch

我们要特别感谢BrianRetford,SunYi,JasonMorton,Shumo,FengBoyuan,Daniel,AaronGreenblatt,NickMatthew,Baz,Marcin,和Brent他们对这篇文章提供的宝贵见解,反馈和审阅。

对于我们这些生活在加密货币之下的人来说,人工智能已经火了一段时间。有趣的是,没人想看到一个AI失控。区块链被发明出来就是为了防止美元失控,所以我们可能会尝试一下。此外,我们现在有了一个新的叫做ZK的技术,它被用来确保事情不会出错。我只是假设普通人对区块链和ZK有一点了解。然而,为了驯服AI这个野兽,我们必须理解AI是如何工作的。

第一部分:易懂的机器学习简介AI已经有了几个名称,从“专家系统”到“神经网络”,然后是“图形模型”,最后是“机器学习”。所有这些都是“AI”的子集,人们给它们不同的名字,我们对AI的了解也更深了。让我们深入了解机器学习,揭开机器学习的神秘面纱。

注意:现今大多数的机器学习模型都是神经网络,因为它们在很多任务上的表现优秀。我们主要将机器学习称为神经网络机器学习。

那么,机器学习是如何工作的呢?

首先,让我们快速了解一下机器学习的内部工作原理:

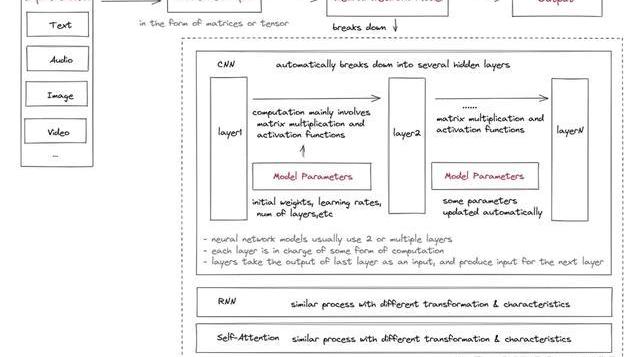

1.输入数据预处理:

输入数据需要被处理成可以作为模型输入的格式。这通常涉及到预处理和特征工程,以提取有用的信息,并将数据转换成适当的形式,例如输入矩阵或张量。这是专家系统的方法。随着深度学习的出现,层的概念开始自动处理预处理的工作。

2.设置初始模型参数:

初始模型参数包括多个层,激活函数,初始权重,偏置,学习率等。有些可以在训练中调整,以使用优化算法提高模型的精度。

3.训练数据:

1)输入被送入神经网络,通常从一层或多层特征提取和关系建模开始,例如卷积层、循环层或自注意力层。这些层学习从输入数据中提取相关特征,并对这些特征之间的关系建模。2)这些层的输出然后通过一个或多个附加层传递,这些附加层对输入数据执行不同的计算和转换。这些层通常主要涉及与可学习权重矩阵的矩阵乘法和非线性激活函数的应用,但它们也可能包括其他操作,例如卷积神经网络中的卷积和池化或递归神经网络中的迭代。这些层的输出作为模型中下一层的输入或作为预测的最终输出。

4.获取模型的输出:

神经网络计算的输出通常是一个向量或矩阵,表示图像分类的概率、情感分析分数或其他结果,具体取决于网络的应用。通常还有另一个错误评估和参数更新模块,它允许根据模型的目的自动更新参数。

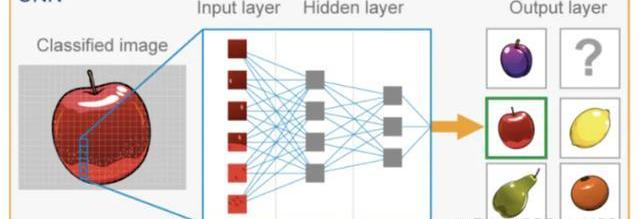

如果上面的解释看起来太晦涩,你可以看看下面使用CNN模型识别苹果图像的例子。

图像作为像素值矩阵载入模型,这个矩阵可以被表示为一个三维张量,其维度为。

卷积神经网络模型的初始参数已设定。

输入图像通过CNN的多个隐藏层,每一层都应用卷积滤波器从图像中提取日益复杂的特征。每一层的输出通过一个非线性激活函数,然后进行池化以减少特征映射的维度。最后一层通常是一个全连接层,根据提取的特征产生输出预测。

某巨鲸花费1,000枚ETH购买2800万枚BALD,损失约34万美元:金色财经报道,据Lookonchain监测,昨日花费500枚ETH购买1360万枚BALD的巨鲸在9小时前再次花费了500枚ETH(93.8万美元)购买了1445万枚BALD。

该巨鲸累计花费1,000枚ETH(187万美元)购买2800万枚BALD,平均购买价格约为0.067美元。以当前价格计算,损失了约34万美元。[2023/7/31 16:08:20]

CNN的最终输出是概率最高的类别。这就是输入图像的预测标签。

机器学习信任框架

我们可以将上述内容总结为一个机器学习信任框架,它包括四个必须可靠的机器学习层次,以使整个机器学习过程可靠:

输入:原始数据需要被预处理,有时还需要保密。完整性:输入数据未被篡改,未被敌对输入污染,并被正确预处理。隐私:如有需要,输入数据不会被泄露。

输出:需要准确生成和传输。完整性:正确生成输出。隐私:如有需要,输出不会被泄露。

模型类型/算法:模型应该被正确计算。完整性:模型被正确执行。隐私:如有需要,模型本身或计算过程不会被泄露。不同的神经网络模型有不同的算法和层次,以满足不同的用例和输入。CNN常用于处理栅格数据,如图像,通过在小输入区域应用卷积运算可以捕获本地模式和特征。另一方面,递归神经网络适合处理顺序数据,如时间序列或自然语言,其中隐藏状态可以捕获来自先前时间步骤的信息并建模时间依赖性。自注意力层对捕捉输入序列中元素之间的关系很有用,使其在需要长距离依赖的任务中非常有效。还存在其他类型的模型,包括多层感知器等。

模型参数:参数在某些情况下应透明或民主生成,但在所有情况下都不易被篡改。完整性:参数以正确的方式生成、维护和管理。隐私:模型所有者通常保密机器学习模型参数,以保护开发模型的组织的知识产权和竞争优势。这只在Transformer模型训练成本极高之前才普遍存在,但无论如何,这对行业来说都是一个主要问题。

第二部分:机器学习的信任问题

随着机器学习应用的爆炸式增长以及它们在日常生活中的融合程度的增加,如ChatGPT的最近流行,对ML的信任问题变得日益重要,不能被忽视。因此,发现并解决这些信任问题对于确保AI的负责任使用和防止其潜在滥用至关重要。然而,这些问题到底是什么呢?让我们深入了解。

缺乏透明度或可证明性

信任问题长期以来一直困扰着机器学习,主要原因有两个:

隐私性:如前所述,模型参数通常是私有的,在某些情况下,模型输入也需要保密,这自然会在模型拥有者和模型使用者之间带来一些信任问题。

算法的黑匣子:机器学习模型有时被称为“黑匣子”,因为它们在计算过程中涉及许多难以理解或解释的自动化步骤。这些步骤涉及复杂的算法和大量数据,这些数据会带来不确定的、有时是随机的输出,使算法成为偏见甚至歧视的罪魁祸首。

在更深入之前,本文中更大的假设是模型已经“准备好使用”,这意味着它训练有素并且适合目的。该模型可能不适合所有情况,并且模型以惊人的速度改进,ML模型的正常保质期为2到18个月不等,具体取决于应用场景。

机器学习信任问题的详细分类

模型训练过程存在信任问题,Gensyn目前正在努力生成有效证据以促进这一过程。但是,本文将主要关注模型推理过程。现在让我们使用ML的四个构建块来发现潜在的信任问题:

Input:

数据源不可篡改

FTX 2.0 Coalition回应Alfred Lin:期待红杉资本与Tribe Capital一起竞购FTX 2.0:金色财经报道,在红杉资本合伙人Alfred Lin在彭博技术峰会上称红杉资本对加密货币概念非常有兴趣而且如果再次评估加密货币交易所FTX可能仍会做出同样的投资决定后,FTX 2.0 Coalition在社交媒体做出回应称,所有FTX投资者现在都有机会通过适当的控制和管理,以熊市估值进行再投资,因此期待红杉资本与Tribe Capital一起与投资银行PWP竞购FTX 2.0。[2023/6/24 21:56:42]

私人输入数据不会被模型运营商窃取

Model:

该模型本身如所宣传的那样准确。

计算过程正确完成。

Parameters:

模型的参数未更改或与宣传的一样。

模型参数对模型所有者来说是宝贵的资产,在此过程中不会泄露

Output:

输出可证明是正确的

ZK如何应用于ML信任框架

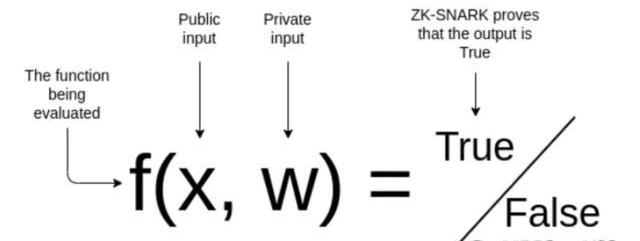

上面的一些信任问题可以通过简单地上链来解决;将输入和ML参数上传到链上,模型计算上链,可以保证输入、参数和模型计算的正确性。但是这种方法可能会牺牲可扩展性和隐私性。Giza在Starknet上是这样做的,但是由于成本问题,它只支持回归这样简单的机器学习模型,不支持神经网络。ZK技术可以更高效地解决上述信任问题。目前ZKML的ZK通常指的是zkSNARK。首先,让我们快速回顾一下zkSNARKs的一些基础知识:

一个zkSNARK证明证明我知道一些秘密输入w使得这个计算的结果f是OUT是真的而不告诉你w是什么。证明生成过程可以概括为几个步骤:

1.制定一个需要证明的陈述:f(x,w)=true

“我已经使用带有私有参数w的ML模型f对这张图像x进行了正确分类。”

2.将语句转换为电路:不同的电路构造方法包括R1CS、QAP、Plonkish等。

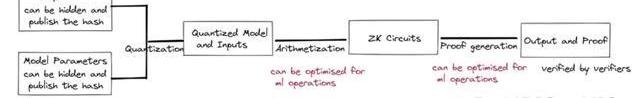

与其他用例相比,ZKML需要一个称为量化的额外步骤。神经网络推理通常在浮点运算中完成,这在运算电路的主要领域中进行仿真是极其昂贵的。不同的量化方法是精度和设备要求之间的权衡。一些电路构造方法如R1CS对神经网络效率不高。可以调整这部分以提高性能。

3.生成证明密钥和验证密钥

4.创建见证人:当w=w*,f(x,w)=true

5.创建哈希承诺:见证人w*承诺使用加密哈希函数生成哈希值。然后可以公开此散列值。

它有助于确保私有输入或模型参数在计算过程中未被篡改或修改。此步骤至关重要,因为即使是微小的修改也会对模型的行为和输出产生重大影响。

6.生成证明:不同的证明系统使用不同的证明生成算法。

需要为机器学习操作设计特殊的零知识规则,例如矩阵乘法和卷积层,从而为这些计算提供具有亚线性时间的高效协议。

由于计算工作量太大,像groth16这样的通用zkSNARK系统可能无法有效地处理神经网络。

自2020年以来,出现了许多新的ZK证明系统来优化模型推理过程的ZK证明,包括vCNN、ZEN、ZKCNN和pvCNN。然而,它们中的大多数都针对CNN模型进行了优化。它们只能应用于某些原始数据集,例如MNIST或CIFAR-10。

2022年,DanielKangTatsunoriHashimoto、IonStoica和YiSun提出了一种基于Halo2的新证明方案,首次实现了ImageNet数据集的ZK证明生成。他们的优化主要落在算术部分,具有新颖的非线性查找参数和跨层子电路的重用。

币安将支持旧Radiant Capital(RDNT)代币充值:3月30日,据官方公告,币安创新区上市Radiant Capital(RDNT)后,许多用户通过旧智能合约地址于币安充值Radiant Capital(RDNT)。因此,币安将支持从旧的Radiant Capital(RDNT)兑换为新的Radiant Capital(RDNT)代币。

所有通过旧智能合约地址充值进来的Radiant Capital(RDNT)代币,将在币安用户的帐户上账为RDNTOLD。持有RDNTOLD的用户可以于2023年3月31日00:00(东八区时间)起,通过闪兑平台以1:1的比例兑换为RDNT。[2023/3/30 13:35:40]

正在对链上推理的不同证明系统进行基准测试,发现在证明时间方面,ZKCNN和plonky2表现最好;在峰值证明者内存使用方面,ZKCNN和halo2表现良好;而plonky,虽然表现不错,但牺牲了内存消耗,ZKCNN仅适用于CNN模型。它还正在开发一个新的zkSNARK系统,特别是针对带有新虚拟机的ZKML。

7.验证证明:验证者使用验证密钥进行验证,无需见证人知晓。

因此,我们可以证明,将零知识技术应用于机器学习模型可以解决很多信任问题。使用交互式验证的类似技术可以实现类似的结果,但将需要验证方更多的资源,并可能面临更多的隐私问题。值得注意的是,根据确切的模型,为它们生成证明可能会耗费时间和资源,因此当该技术最终在实际用例中实施时,会在各个方面做出妥协。

解决方案的现状

接下来,桌子上有什么?请记住,模型提供者可能不想生成ZKML证明的原因有很多。对于那些有足够勇气尝试ZKML并且当解决方案对实施有意义时,他们可以根据他们的模型和输入所在的位置从几个不同的解决方案中进行选择:

如果输入数据在链上,Axiom可以被视为一种解决方案:

Axiom正在为以太坊构建一个ZK协处理器,以改善用户对区块链数据的访问并提供更复杂的链上数据视图。对链上数据进行可靠的机器学习计算是可行的:

首先,Axiom通过将以太坊区块哈希的Merkle根存储在其智能合约AxiomV0中来导入链上数据,这些数据通过ZK-SNARK验证过程进行无信任验证。然后,AxiomV0StoragePf合约允许根据缓存在AxiomV0中的块哈希给出的信任根,批量验证任意历史以太坊存储证明。接下来,可以从导入的历史数据中提取ML输入数据。然后Axiom可以在上面应用经过验证的机器学习操作;使用优化的halo2作为后端来验证每个计算的有效性。最后,Axiom为每个查询的结果附上zk证明,Axiom智能合约将验证zk证明。任何想要证明的相关方都可以从智能合约中访问它。

如果模型上链,可以考虑RISCZero作为解决方案:

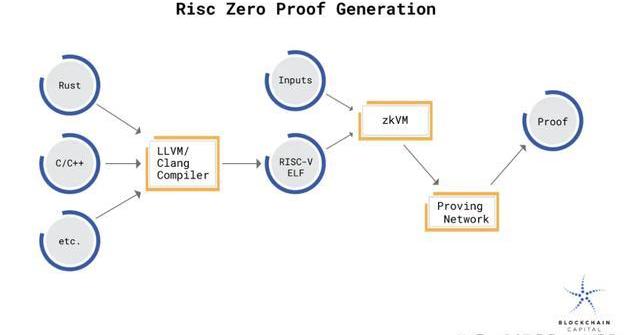

RISC零ZKVM是一个RISC-V虚拟机,它产生它执行的代码的零知识证明。使用ZKVM,生成加密收据,任何人都可以验证它是由ZKVM的访客代码生成的。发布收据不会透露有关代码执行的其他信息。

通过在RISCZero的ZKVM中运行机器学习模型,可以证明执行了模型中涉及的精确计算。计算和验证过程可以在用户首选环境中的链下完成,也可以在通用汇总的盆景网络中完成。

首先,模型的源代码需要编译成RISC-V二进制文件。当这个二进制文件在ZKVM中执行时,输出与包含加密印章的计算收据配对。该印章用作计算完整性的零知识论证,并将加密imageID链接到断言的代码输出,第三方可以快速验证。当模型在ZKVM中执行时,关于状态变化的计算完全在VM中完成。它不会向外部各方泄露有关模型内部状态的任何信息。一旦模型完成执行,生成的印章将作为计算完整性的零知识证明。

web3初创公司Tesseract宣布完成7800万美元融资:金色财经报道,前Revolut员工为Tesseract筹集了7800万美元,这是一家旨在将能源业务代币化的web3初创公司。?Tesseract已经筹集了3000万美元的传统股权,其余金额通过出售其原生代币筹集。本轮融资的支持者包括风险投资公司Balderton、Lakestar、Accel、Low Carbon、Ribit Capital、Box Group和前一级方程式赛车手Nico Rosberg。[2022/9/7 13:14:22]

生成ZK证明的确切过程涉及一个以随机预言机作为验证者的交互协议。RISC零收据上的印章本质上是此交互协议的抄本。

如果您想直接从Tensorflow或Pytorch等常用的ML软件导入模型,可以考虑使用ezkl作为解决方案:

Ezkl是一个库和命令行工具,用于对zkSNARK中的深度学习模型和其他计算图进行推理。

首先,将最终模型导出为.onnx文件,并将一些样本输入导出为.json文件。然后,将ezkl指向.onnx和.json文件以生成ZK-SNARK电路,您可以使用它来证明ZKML语句。

看起来很简单,对吧?ezkl的目标是提供一个抽象层,允许在Halo2电路中调用和布置更高级别的操作。Ezkl抽象化了很多复杂性,同时保持了难以置信的灵活性。他们的量化模型有一个用于自动量化的比例因子。随着新解决方案的出现,它们支持对其他证明系统进行灵活更改。它们还支持多种类型的虚拟机,包括EVM和WASM。

在证明系统方面,ezklcustomshalo2circuits通过聚合证明和递归。Ezkl还使用融合和抽象优化了整个过程

另外值得注意的是,相对于其他通用的zkml项目,AccessorLabs专注于提供专为全链上游戏设计的zkml工具,可能涉及AINPC、游戏玩法自动更新、涉及自然语言的游戏界面等。

第三部分:用例在哪里?

使用ZK技术解决ML的信任问题意味着它现在可以应用于更多“高风险”和“高度确定性”的用例,而不仅仅是跟上人们的谈话或区分猫的图片和狗的图片。Web3已经在探索很多这样的用例。这并非巧合,因为大多数Web3应用程序在区块链上运行或打算在区块链上运行,因为区块链的特定性质可以安全运行、难以篡改并具有确定性计算。一个可验证的行为良好的人工智能应该是一个能够在去信任和去中心化的环境中进行活动的人工智能,对吧?

ZK+ML有效的Web3用例

许多Web3应用程序为了安全和去中心化而牺牲用户体验,因为这显然是他们的首要任务,并且基础设施的限制也存在。AI/ML有可能丰富用户体验,这肯定会有所帮助,但以前似乎不可能不妥协。现在,感谢ZK,我们可以轻松地看到AI/ML与Web3应用程序的结合,而不会在安全性和去中心化方面做出太多牺牲。

本质上,它将是一个以无信任方式实现ML/AI的Web3应用程序。通过去信任的方式,我们的意思是它是否在去信任的环境/平台中运行,或者它的操作是可证明可验证的。请注意,并非所有ML/AI用例都需要或首选以去信任的方式运行。我们将分析在各种Web3领域中使用的ML功能的每个部分。然后,我们会识别出需要ZKML的部分,通常是人们愿意花额外的钱来证明的高价值部分。

下面提到的大多数用例/应用程序仍处于实验研究阶段。因此,它们离实际采用还很远。我们稍后会讨论原因。

HyperPay新版本发布,Web3钱包增加安全检测中心:据官方消息,HyperPay钱包发布V5.0.9版本,在该版本中新增安全中心功能,提供环境检测、代币安全检测和授权检测三项安全监测功能,另外授权检测模块还提供了修改/取消授权的功能;自管钱包全新升级,HyperPay Web3钱包支持33+公链和主流公链DApp,优化了助记词导入/创建流程,满足用户更多使用需求,并将支持更多公链NFT资产查询及转账功能,Web3钱包发现版块上线\"A or B\"功能。[2022/8/25 12:47:57]

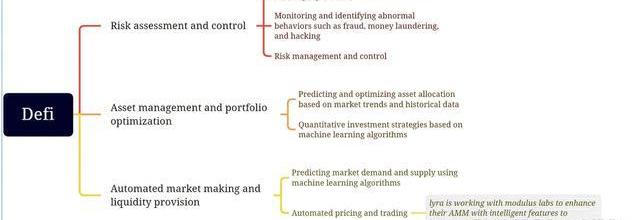

Defi

Defi是为数不多的适合区块链协议和Web3应用程序的产品市场之一。能够以无需许可的方式创造、存储和管理财富和资本在人类历史上是前所未有的。我们已经确定了许多AI/ML模型需要在未经许可的情况下运行以确保安全性和去中心化的用例。

风险评估:现代金融需要AI/ML模型进行各种风险评估,从防止欺诈和到发放无抵押贷款。确保这个AI/ML模型以可验证的方式运行意味着我们可以防止它们被操纵进入审查制度,这阻碍了使用Defi产品的无许可性质。

资产管理:自动交易策略对于Tradfi和Defi来说并不新鲜。已经尝试应用AI/ML生成的交易策略,但只有少数去中心化策略获得成功。目前defi领域的典型应用包括ModulusLabs试验的rockybot。

TheRockyBot:ModulusLabs在StarkNet上创建了一个交易机器人,使用人工智能进行决策。

在Uniswap上持有资金并交换WEth/USDC的L1合约。这适合ML信任框架的“输出”部分。输出在L2上生成,传输到L1并用于执行。在此过程中,它不能被篡改。L2合约实现了一个简单的3层神经网络来预测未来的WEth价格。该合约使用历史WETH价格信息作为输入。这适合“输入”和“模型”部分。历史价格信息输入来自区块链。模型的执行是在CairoVM中计算的,CairoVM是一个ZKVM,其执行轨迹将生成ZK证明以供验证。用于训练回归器和分类器的可视化和PyTorch代码的简单前端。

自动化MM和流动性供应:这本质上是在风险评估和资产管理方面进行的类似努力的组合,只是在涉及数量、时间表和资产类型时以不同的方式进行。关于机器学习如何用于股票市场做市的论文很多。其中一些适用于Defi产品可能只是时间问题。

例如,LyraFinance正在与ModulusLabs合作,通过智能功能增强他们的AMM,以提高资本效率。

荣誉奖:Warp.cc团队开发了一个教程项目,介绍如何部署运行训练有素的神经网络以预测比特币价格的智能合约。这属于我们框架的“输入”和“模型”部分,因为输入由RedStoneOracles提要提供,并且模型作为Arweave上的Warp智能合约执行。这是第一次迭代并且涉及到ZK,所以它属于我们的荣誉奖,但在未来Warp团队考虑实现ZK部分

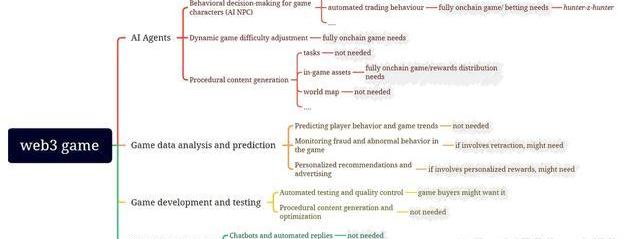

Gaming

游戏与机器学习有很多交集:

图中的灰色区域代表我们对游戏部分的ML功能是否需要与相应的ZKML证明配对的初步评估。LeelaChessZero是将ZKML应用于游戏的一个非常有趣的示例:

AIAgents

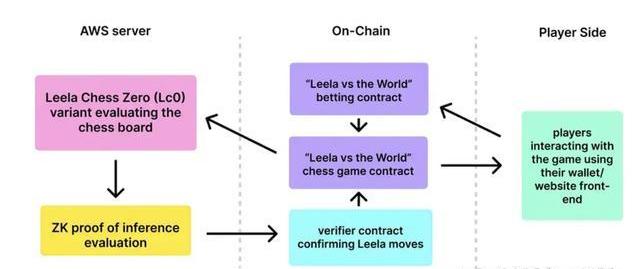

LeelaChessZero(LC0):由ModulusLabs打造的完全链上人工智能国际象棋棋手,与来自社区的一群人类棋手对弈。

LC0和人类集体轮流下棋。

LC0的移动是使用简化的、电路友好的LC0模型计算的。

LC0的举动生成了Halo2snark证明,以确保没有人为策划干预。只有简化的LC0模型可以做出决定。

这适合“模型”部分。该模型的执行具有ZK证明,以验证计算未被篡改。

数据分析和预测:这是AI/ML在Web2游戏世界中的常见用途。然而,我们发现很少有理由将ZK实施到这个ML过程中。为了不直接参与该过程的太多价值,可能不值得付出努力。但是,如果使用某些分析和预测来确定用户的奖励,则可能会实施ZK以确保结果正确。

荣誉奖:

AIArena是一款以太坊原生游戏,全世界的玩家都可以在其中设计、训练和战斗由人工神经网络驱动的NFT角色。来自世界各地的才华横溢的研究人员竞相创建最佳的机器学习(ML)模型以在游戏中进行战斗。AIArena专注于前馈神经网络。通常,它们的计算开销低于卷积神经网络(CNN)或递归神经网络(RNN)。不过,就目前而言,模型只有在经过训练后才会上传到平台,因此值得一提。

GiroGiro.AI正在构建一个AI工具包,使大众能够创建用于个人或商业用途的人工智能。用户可以基于直观和自动化的AI工作流平台创建各种AI系统。只需输入少量数据并选择算法,用户就会在脑海中生成和利用AI模型。尽管该项目处于非常早期的阶段,但由于GiroGiro专注于gamefi和以虚拟世界为重点的产品,因此我们非常期待看到它能带来什么,因此它获得了荣誉奖。

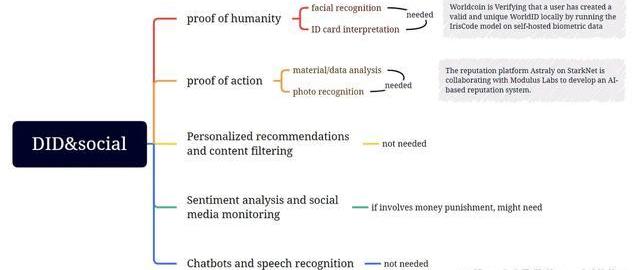

DID和社交

在DID&social领域,web3和ml的交集目前主要在proofofhumanity和proofofcredentials领域;其他部分可能会发展,但需要更长的时间。

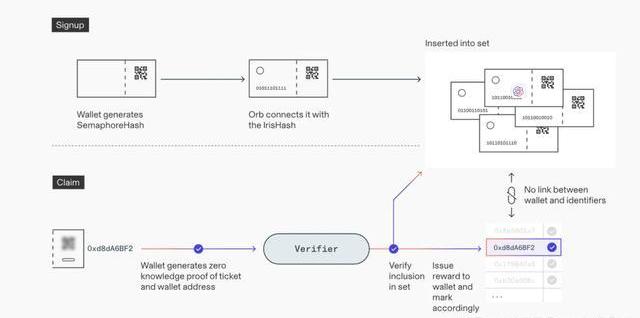

人性的证明

Worldcoin使用一种称为Orb的设备来确定某人是否是一个没有试图验证的真实存在的人。它通过各种相机传感器和分析面部和虹膜特征的机器学习模型来实现这一点。一旦做出决定,Orb就会拍摄一组人的虹膜照片,并使用多种机器学习模型和其他计算机视觉技术来创建虹膜代码,这是个人虹膜图案最重要特征的数字表示。具体报名步骤如下:

用户在她的手机上生成一个信号量密钥对,并将散列的公钥提供给Orb。Orb扫描用户的虹膜并在本地计算用户的IrisHash。然后,它将包含散列公钥和IrisHash的签名消息发送到注册定序器节点。定序器节点验证Orb的签名,然后检查IrisHash是否与数据库中已有的不匹配。如果唯一性检查通过,则保存IrisHash和公钥。

Worldcoin使用开源的Semaphore零知识证明系统将IrisHashes的唯一性转移到用户帐户的唯一性,而无需将它们链接起来。这确保了新注册的用户可以成功领取他/她的WorldCoins。步骤如下:

用户的应用程序在本地生成一个钱包地址。该应用程序使用信号量来证明它拥有先前注册的一个公钥的私有副本。因为它是零知识证明,所以它不会透露哪个公钥。证明再次发送到排序器,排序器对其进行验证并启动将代币存入提供的钱包地址。一个所谓的无效符与证明一起发送,并确保用户不能两次要求奖励。

WorldCoin使用ZK技术确保其ML模型的输出不会泄露用户的个人数据,因为它们不会相互关联。在这种情况下,它属于我们信任框架的“输出”部分,因为它确保输出以所需方式传输和使用,在这种情况下是私密的。

行动证明

Astraly是一个建立在StarkNet上的基于声誉的代币分发平台,用于寻找和支持最新最好的StarkNet项目。衡量声誉是一项具有挑战性的任务,因为它是一个抽象概念,无法用简单的指标轻松量化。在处理复杂的指标时,通常情况下,更全面和多样化的输入会产生更好的结果。这就是为什么Astraly正在寻求moduluslabs的帮助,以使用ML模型来提供更准确的声誉评级。

个性化推荐和内容过滤

Twitter最近为“为你”时间线开源了他们的算法,但用户无法验证该算法是否正确运行,因为用于对推文进行排名的ML模型的权重是保密的。这导致了对偏见和审查制度的担忧。

然而,DanielKang、EdwardGan、IonStoica和YiSun提供了一种解决方案,使用ezkl提供证据证明Twitter算法在不泄露模型权重的情况下诚实运行,从而帮助平衡隐私和透明度。通过使用ZKML框架,Twitter可以提交其排名模型的特定版本,并发布证据证明它为给定用户和推文生成了特定的最终输出排名。该解决方案使用户能够验证计算是否正确执行,而无需信任系统。虽然要使ZKML更加实用还有很多工作要做,但这是提高社交媒体透明度的积极步骤。因此,这属于我们的ML信任框架的“模型”部分。

从用例角度重新审视ML信任框架

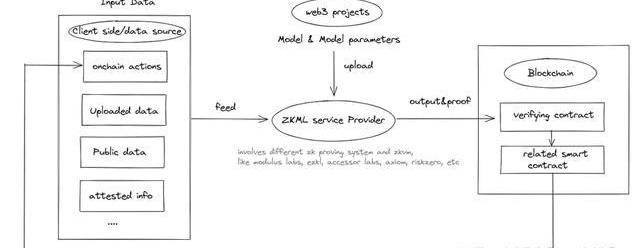

可以看出,ZKML在web3中的潜在用例仍处于起步阶段,但不容忽视;未来随着ZKML的使用范围不断扩大,可能会出现对ZKML提供者的需求,形成下图的闭环:

ZKML服务提供商主要关注ML信任框架的“模型”和“参数”部分。尽管我们现在看到的大多数与“模型”相关而不是“参数”。请注意,“输入”和“输出”部分更多地由基于区块链的解决方案解决,用作数据源或数据目的地。单独的ZK或区块链可能无法实现完全可信,但它们联合起来可能会做到。

离大规模采用还有多远?

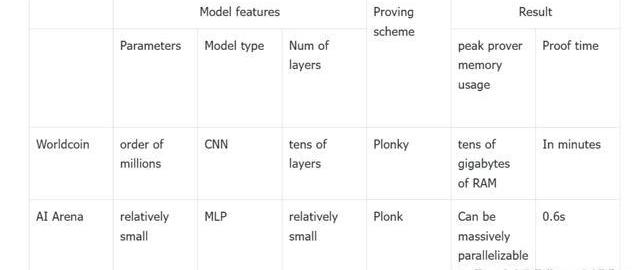

ModulusLabs的论文通过测试Worldcoin和AIArena,为我们提供了一些关于ZKML应用可行性的数据和见解:

如果Worldcon使用ZKML,证明者的内存消耗将超过任何商用移动硬件。如果AIArena的锦标赛使用ZKML,则使用ZKCNN会将时间和成本增加到100倍。所以遗憾的是,直接应用ZKML技术来证明时间和证明内存使用都是不可行的。

证明大小和验证时间如何?我们可以参考DanielKang、TatsunoriHashimoto、IonStoica和YiSun的论文。如下图所示,他们的DNN推理解决方案可以在ImageNet上实现高达79%的准确率,同时只需10秒和5952字节的验证时间。此外,zkSNARKs可以缩小到只需0.7秒即可以59%的准确率进行验证。这些结果表明zkSNARKingImageNet规模模型在证明大小和验证时间方面的可行性。

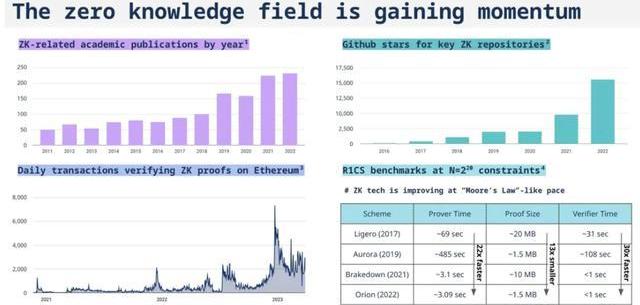

现在主要的技术瓶颈在于时间和内存消耗的证明。在web3案例中应用ZKML在技术上仍然不可行。ZKML能否抓住AI的发展潜力?我们可以对比几个经验数据:

ML模型的发展速度:2019年发布的GPT-1模型有1.5亿个参数,而2020年最新发布的GPT-3模型有1750亿个参数,参数数量在短短两年内增长了1166倍.

ZK系统的优化速度:ZK系统的性能增长基本遵循“摩尔定律”式的步伐。?几乎每年都会推出新的ZK系统,我们预计证明者性能的火箭式增长将持续一段时间。

比较前沿的ML对ZK的提升幅度,前景不是很乐观。然而,随着rollup性能、ZK硬件以及基于高度结构化神经网络操作的量身定制的ZK证明系统的不断改进,希望ZKML的开发能够满足web3的需求,并从提供一些老式的机器学习功能开始第一的。

尽管我们可能很难使用区块链+ZK来验证ChatGPT提供给我的信息是否值得信赖,但我们或许能够将一些更小和更旧的ML模型放入ZK电路中。

第四部分:结论

“权力导致腐败,绝对的权力导致绝对的腐败”。凭借AI和ML令人难以置信的力量,目前还没有万无一失的方法将其置于治理之下。政府一再证明可以为后果提供后期干预或早期彻底禁止。区块链+ZK提供了能够以可证明和可验证的方式驯服野兽的少数解决方案之一。

我们期待在ZKML领域看到更多的产品创新,ZK和区块链为AI/ML的运行提供安全可信的环境。我们还期望全新的商业模式会从这些产品创新中产生,因为在无需许可的加密世界中,我们不受这里首选的SaaS商业化模式的限制。我们期待支持更多的建设者前来,在这个“狂野西部无政府状态”和“象牙塔精英”的迷人重叠中构建他们激动人心的想法。

我们还早,但我们可能会在路上拯救世界。

最新投融资公司评测 近日,超高效液相色谱领军企业科诺美科技有限公司宣布完成近亿元A轮融资,本轮融资由华盖资本领投、爱博清石基金跟投,老股东元生创投继续追加投资.

1900/1/1 0:00:00一、NFT概述 5月对于NFT来说是个好月份,因为市场上充满了很多活动。主要区块链的NFT市场交易量为6.6亿美元,比上月增长5.6%.

1900/1/1 0:00:00赢牛商盟健康家居生活有限公司旗下火天大有服务平台荣幸宣布,该平台最近获得了“绿色消费积分信用认证企业”殊荣.

1900/1/1 0:00:00今天我们先来做个小测试,请大家仔细阅读下面这段话并回答下列问题:众所周知賢鏛在我们日常生活中有着重要地位.

1900/1/1 0:00:00关于MXCMXC极域基金会致力于低功耗广域物联网(LPWAN)与区块链数据跨链技术的研究应用。MXProtocol极域协议是MXC的核心,是基于LPWAN基础之上的完全去中心化的标准协议,解决如.

1900/1/1 0:00:001我们知道,人类只有在原始公有制社会,才能实现民主制和人人基本平等。私有化以后,必然发展到“一家天下”的君主制,同时必然等级森严,社会不平等.

1900/1/1 0:00:00