撰文:TanyaMalhotra

来源:Marktechpost

编译:DeFi之道

图片来源:由无界版图AI工具生成

随着生成性人工智能在过去几个月的巨大成功,大型语言模型正在不断改进。这些模型正在为一些值得注意的经济和社会转型做出贡献。OpenAI开发的ChatGPT是一个自然语言处理模型,允许用户生成有意义的文本。不仅如此,它还可以回答问题,总结长段落,编写代码和电子邮件等。其他语言模型,如Pathways语言模型、Chinchilla等,在模仿人类方面也有很好的表现。

Qredo Network宣布集成BNB Chain:9月5日,据官方消息,Qredo Network宣布集成BNB Chain。Qredo用户可以在Qredo Network上交易、转移和托管BNB(BEP20)和BUSD(BEP20)。[2022/9/6 13:10:26]

大型语言模型使用强化学习来进行微调。强化学习是一种基于奖励系统的反馈驱动的机器学习方法。代理通过完成某些任务并观察这些行动的结果来学习在一个环境中的表现。代理在很好地完成一个任务后会得到积极的反馈,而完成地不好则会有相应的惩罚。像ChatGPT这样的LLM表现出的卓越性能都要归功于强化学习。

元宇宙项目启动平台FireStarter集成Chainlink VRF,以确保公平分配奖励:10月16日消息,元宇宙项目Launchpad FireStarter宣布,已集成Chainlink可验证随机函数(VRF),以帮助确保在FireStarter Champion NFT持有者之间公平分配独家内容、NFT和其他平台利益。Hiro和FireStarter Metaverse Champions将帮助用户访问IMO融资过程的不同级别和社区福利。[2021/10/16 20:34:17]

ChatGPT使用来自人类反馈的强化学习,通过最小化偏差对模型进行微调。但为什么不是监督学习呢?一个基本的强化学习范式由用于训练模型的标签组成。但是为什么这些标签不能直接用于监督学习方法呢?人工智能和机器学习研究员SebastianRaschka在他的推特上分享了一些原因,即为什么强化学习被用于微调而不是监督学习。

美国SEC指控DeFi公司Blockchain Credit Partners涉嫌欺诈性发行3000万美元:8月6日消息,美国证券交易委员会指控DeFi贷款人Blockchain Credit Partners及其两名高管通过涉嫌欺诈性发行筹集3000万美元。美国证券交易委员会周五表示,该案是该机构首次涉及使用DeFi技术的证券,佛罗里达州男子Gregory Keough、Derek Acree和他们的公司Blockchain Credit Partners在未注册的发行中使用智能合约出售支付超过6%利息的代币,销售证券。(Coindesk)[2021/8/6 1:39:48]

动态 | 区块链求职平台ScoutChain在韩国推出:据Aimgroup消息,一个新的韩国求职网站ScoutChain.io正在利用区块链技术将求职者和职位联系起来,减少中间人。[2018/9/24]

不使用监督学习的第一个原因是,它只预测等级,不会产生连贯的反应;该模型只是学习给与训练集相似的反应打上高分,即使它们是不连贯的。另一方面,RLHF则被训练来估计产生反应的质量,而不仅仅是排名分数。

SebastianRaschka分享了使用监督学习将任务重新表述为一个受限的优化问题的想法。损失函数结合了输出文本损失和奖励分数项。这将使生成的响应和排名的质量更高。但这种方法只有在目标正确产生问题-答案对时才能成功。但是累积奖励对于实现用户和ChatGPT之间的连贯对话也是必要的,而监督学习无法提供这种奖励。

不选择SL的第三个原因是,它使用交叉熵来优化标记级的损失。虽然在文本段落的标记水平上,改变反应中的个别单词可能对整体损失只有很小的影响,但如果一个单词被否定,产生连贯性对话的复杂任务可能会完全改变上下文。因此,仅仅依靠SL是不够的,RLHF对于考虑整个对话的背景和连贯性是必要的。

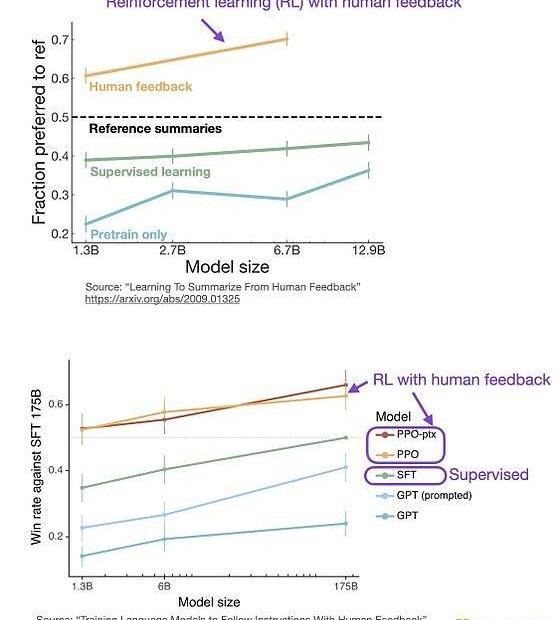

监督学习可以用来训练一个模型,但根据经验发现RLHF往往表现得更好。2022年的一篇论文《从人类反馈中学习总结》显示,RLHF比SL表现得更好。原因是RLHF考虑了连贯性对话的累积奖励,而SL由于其文本段落级的损失函数而未能很好做到这一点。

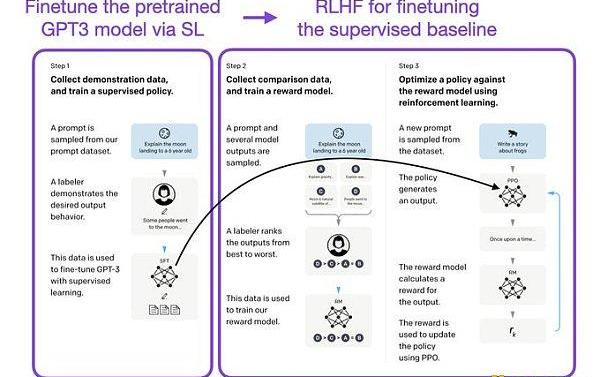

像InstructGPT和ChatGPT这样的LLMs同时使用监督学习和强化学习。这两者的结合对于实现最佳性能至关重要。在这些模型中,首先使用SL对模型进行微调,然后使用RL进一步更新。SL阶段允许模型学习任务的基本结构和内容,而RLHF阶段则完善模型的反应以提高准确性。

标签:CHAHAIAINChainDigital Financial ExchangevabonchainConcern Poverty ChainRentalChain

撰文:TengYan时光飞逝,2023年的第1季度即将结束。如果你没有时间跟上NFT领域,别担心,我会帮你的。我将提炼出2月发生的主要事件、我最兴奋的趋势,以及我对BLUR代币发布的看法.

1900/1/1 0:00:00除了在EVM兼容方面的优秀表现,Scroll证明节点的去中心化和开源的社区经营都体现了以太坊的正统性,达到了价值观层面的「兼容」,顶级硬件速度为Scroll注入了更大的潜力.

1900/1/1 0:00:00作者:yyyTwitter:@y_cryptoanalyst?前言Coinbase正大刀阔斧地建设链上基础设施,近日宣布基于OPStack构建一条二层Rollup链——Base.

1900/1/1 0:00:00撰文:MaryLiu加密社区最期待的大事之一--Arbitrum空投--终于来了。ArbitrumFoundation宣布将于3月23日向其社区成员空投ARB治理代币,并启动其第3层开发工具Ar.

1900/1/1 0:00:002023会是ZK大年吗?ZK作为L2、隐私、跨链等概念下的核心技术派系,该板块热度自2022年延续至今;近期的?ETHdenver大会上,ZK持续高热.

1900/1/1 0:00:00原文作者:@Ryanqyz_hodl原文来源:SevenUpDAO摘要:(?1)估值:与OP比较,使用FDV相对估值,SARB的价格应在2.088左右。使用MCap相对估值,价格在1.23左右.

1900/1/1 0:00:00